Las arquitecturas de despliegue de la seguridad de red experimentan una evolución regular, impulsada por diversos requisitos empresariales.

Las arquitecturas de despliegue de la seguridad de red experimentan una evolución regular, impulsada por diversos requisitos empresariales.

A continuación se describen algunas de las tendencias recientes del sector:

- Minimizar el coste y la carga de mantenimiento asociados a sistemas de seguridad de red dispares y múltiples.

- Implementar un mandato de «Cero confianza en todas partes» que abarque todas las redes dentro de los centros de datos, a través de las WAN y dentro de los clústeres Kubernetes.

- Garantizar un alto rendimiento (rendimiento, latencia reducida y fluctuación mínima) para mejorar la experiencia del usuario y admitir aplicaciones en tiempo real como WebRTC.

- Satisfacer las necesidades de una mano de obra distribuida.

- Satisfacer las demandas de mano de obra a distancia.

- Aumento de la adopción de servicios SaaS por parte de las empresas.

- Creciente dependencia de la nube para las aplicaciones empresariales.

- Adoptar despliegues multi-nube.

- Exploración de las ventajas potenciales de la computación Edge y Fog.

- Dificultad para formar o adquirir personal cualificado en funciones de red y seguridad.

- Minimización de los recursos necesarios para gestionar la conectividad a Internet de última milla para las oficinas distribuidas.

Red heredada y arquitectura de seguridad

Las empresas con múltiples oficinas y fuerzas de trabajo remotas asignaban tradicionalmente importantes recursos a la adquisición y el mantenimiento de su infraestructura de redes y seguridad.

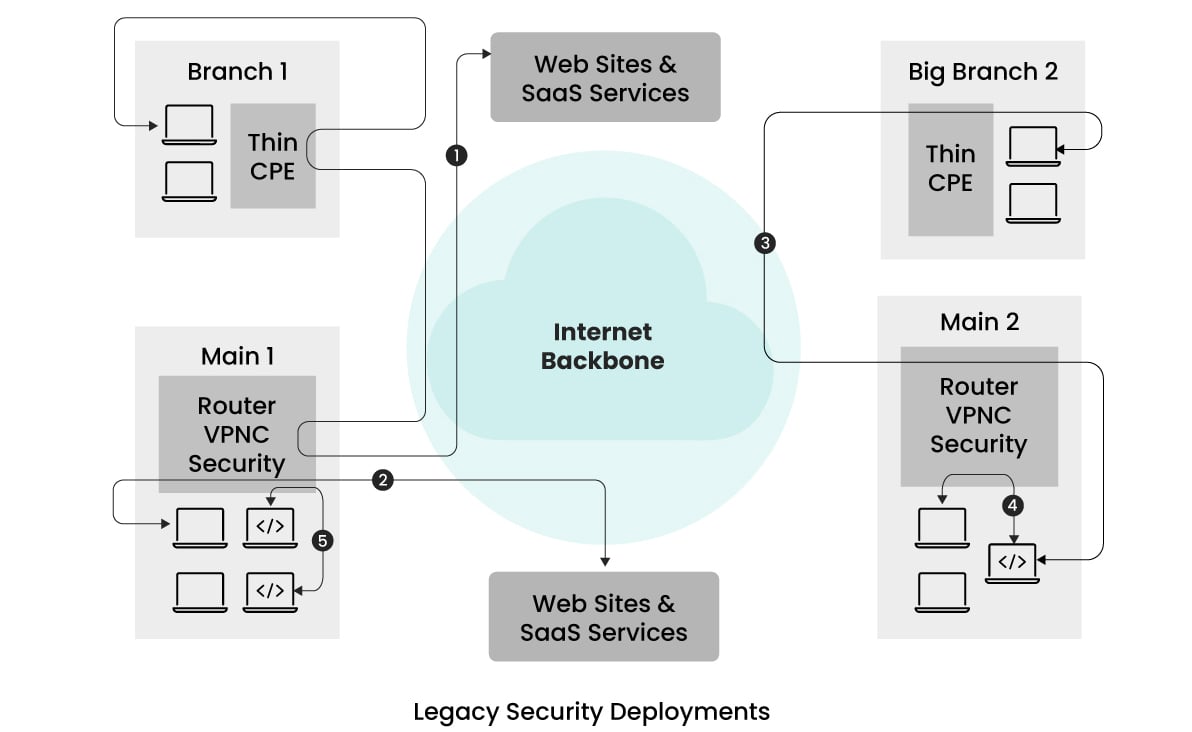

La siguiente ilustración simplificada muestra la arquitectura típica adoptada anteriormente.  Este ejemplo muestra una empresa con dos sucursales y dos oficinas principales situadas en distintas partes del mundo.

Este ejemplo muestra una empresa con dos sucursales y dos oficinas principales situadas en distintas partes del mundo.

En un esfuerzo por reducir los gastos en dispositivos de seguridad y aliviar la sobrecarga de gestión, toda la aplicación de la seguridad se centraliza en las oficinas principales.

El tráfico procedente de las sucursales y de los usuarios remotos se enruta a las oficinas principales cercanas para que se aplique la seguridad antes de dirigirse a su destino previsto.

Los dispositivos «Thin CPE» suelen desplegarse en las sucursales para facilitar este tunelado del tráfico.

Las oficinas principales están equipadas con concentradores VPN para terminar los túneles, múltiples dispositivos de seguridad para detectar y eliminar exploits, implementar controles de acceso granulares, blindar contra malware y prevenir ataques de phishing.

Sin embargo, como se ilustra en los flujos de tráfico (flujos representados por 1 en la imagen), el tráfico de las sucursales a los sitios de Internet sigue un enrutamiento capilar.

Este encaminamiento puede dar lugar a un aumento de la latencia y, en consecuencia, a experiencias de usuario subóptimas, especialmente si la sucursal y las oficinas principales cercanas están situadas a una distancia considerable.

Algunas empresas intentaron mejorar el rendimiento y reducir las fluctuaciones empleando enlaces dedicados, pero estas soluciones resultaban costosas y no resolvían adecuadamente los problemas de latencia.

Además, la gestión de múltiples dispositivos de red y seguridad, cada uno con su propia configuración y panel de análisis, plantea desafíos.

Esta complejidad puede dar lugar a configuraciones propensas a errores debido a la necesidad de formar al personal en múltiples interfaces.

Estas arquitecturas de seguridad heredadas a menudo pasaban por alto los principios de confianza cero, confiando más en la segmentación de la red y las direcciones IP que en proporcionar un control de acceso basado en el usuario y supeditado a la autenticación del mismo.

Aunque este enfoque funcionó eficazmente en su momento, el aumento de los escenarios de trabajo remoto y el uso extensivo de NAT (traducción de direcciones de red) hicieron que la identificación de usuarios mediante direcciones IP fuera cada vez más difícil.

En consecuencia, esta tensión empezó a revelar las limitaciones de las arquitecturas heredadas.

Seguridad en la nube/POP

En respuesta a los retos relacionados con el mantenimiento de la infraestructura de seguridad in situ, la adaptación a las exigencias del trabajo a distancia, la reducción de la latencia asociada a la capilaridad del tráfico y el uso ampliado de los servicios en la nube y SaaS, las soluciones de seguridad basadas en la nube han surgido como una alternativa prometedora.

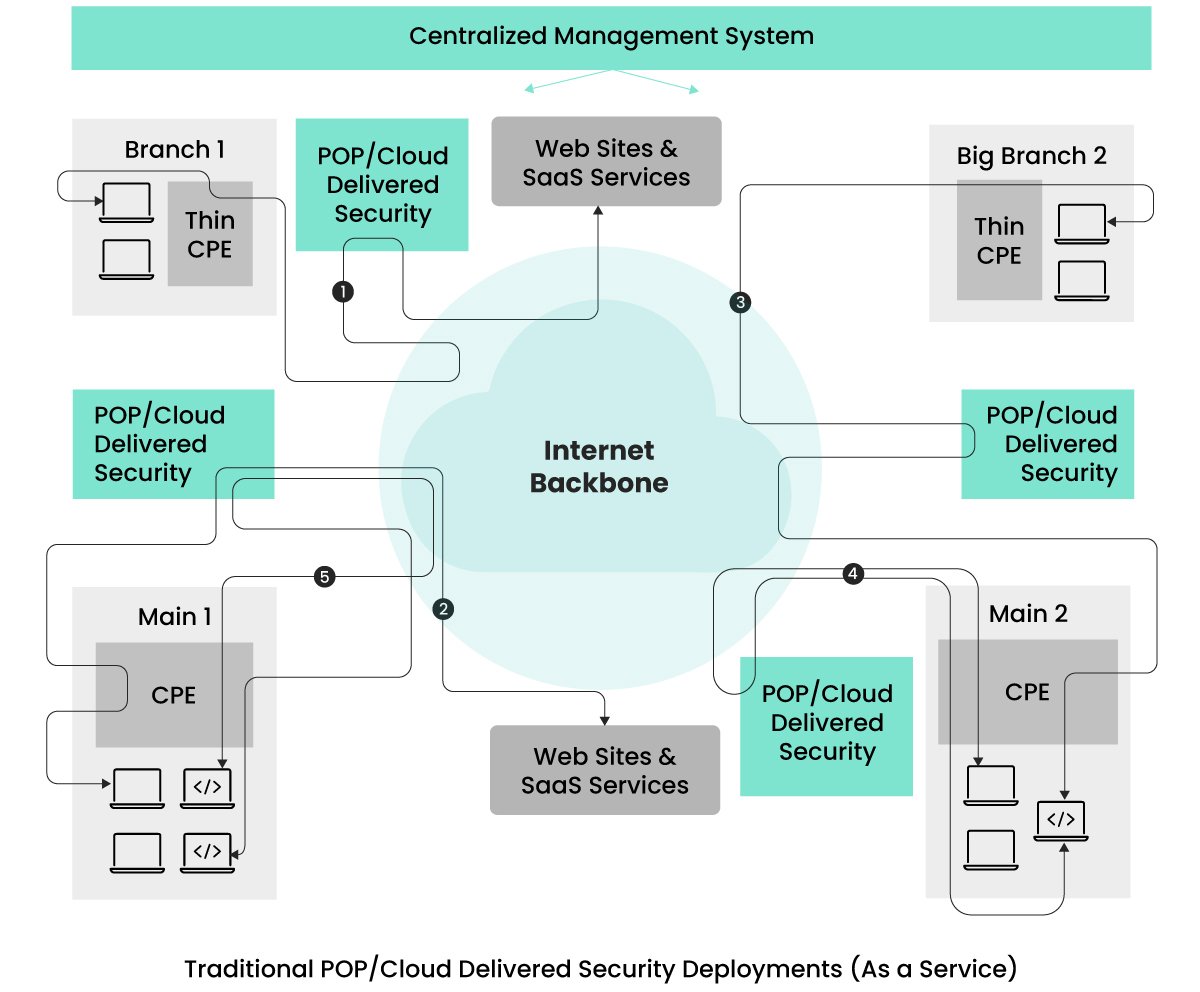

Muchas empresas han empezado a aprovechar estas soluciones de seguridad basadas en la nube para abordar estos problemas, como se muestra en la imagen inferior.  El proveedor distribuye los servicios de seguridad a través de varios puntos de presencia (POP).

El proveedor distribuye los servicios de seguridad a través de varios puntos de presencia (POP).

Las empresas tienen la flexibilidad de seleccionar las ubicaciones de los POP en función de la ubicación de sus oficinas y de la concentración de su personal remoto.

El tráfico de clientes destinado a cualquier ubicación se enruta a través del POP más cercano donde se aplica la seguridad.

Este enrutamiento se facilita utilizando dispositivos CPE en las oficinas y software cliente VPN en los dispositivos de los usuarios remotos, lo que reduce la latencia asociada a la arquitectura de seguridad heredada debido a la proximidad de las ubicaciones de los POP.

Inicialmente, el sector contaba con servicios de seguridad de múltiples proveedores, pero se ha producido un cambio hacia servicios de seguridad en la nube basados en tecnologías unificadas de un único proveedor.

Estos servicios unificados ofrecen una configuración de seguridad racionalizada y una gestión de la observabilidad, lo que soluciona la gestión fragmentada de la seguridad de las arquitecturas de despliegue heredadas.

Aunque esta configuración funciona bien para el tráfico destinado a Internet/sitios SaaS, introduce un nuevo reto cuando ambas entidades comunicantes se encuentran en el mismo sitio, centro de datos o dentro de un clúster Kubernetes, como se ve en los flujos (4) y (5).

El flujo (4) representa el tráfico entre entidades dentro del mismo sitio que se tuneliza a la ubicación POP más cercana y luego se enruta de vuelta.

Esto se hace para aplicar medidas de seguridad a todos los flujos de tráfico, cumpliendo los requisitos de confianza cero.

El flujo (5) ilustra la comunicación entre dos servicios de aplicación que, para cumplir las exigencias de confianza cero, se enruta fuera del sitio hasta el POP más cercano para su procesamiento de seguridad antes de regresar al mismo clúster Kubernetes.

Este proceso aumenta inadvertidamente la latencia de estos flujos y puede exponer el tráfico a entidades adicionales de forma innecesaria.

Algunas empresas evitan esta latencia desplegando diferentes dispositivos de seguridad en las instalaciones, pero esto reintroduce los retos asociados a las arquitecturas de despliegue heredadas.

Otro reto de la seguridad proporcionada por POP está relacionado con el aislamiento del rendimiento.

Como estos proveedores prestan servicio a múltiples clientes/arrendatarios, se dan casos de retos de rendimiento relacionados con vecinos ruidosos.

Es decir, el volumen de tráfico de otras empresas puede afectar al rendimiento del tráfico de su empresa.

Esto se debe a que se comparte el mismo contexto de ejecución para el tráfico procedente de varias empresas.

A medida que las empresas buscan soluciones que cumplan los requisitos de confianza cero, ofrezcan una gestión unificada de las políticas, proporcionen un aislamiento del rendimiento y mitiguen la latencia innecesaria del hair-pinning, el sector de la seguridad de redes ha hecho evolucionar sus arquitecturas de despliegue para dar respuesta a estas preocupaciones.

El Servicio de Acceso Seguro Unificado Edge (SASE), proporcionado por empresas como Aryaka, ha surgido para desempeñar un papel fundamental en este panorama.

SASE unificado con servicios de seguridad híbridos y distribuidos

Una arquitectura ideal es la que alivia las complejidades de gestión de las arquitecturas anteriores, cumple los estrictos requisitos de confianza cero, garantiza un nivel de seguridad igual para los flujos de tráfico Norte-Sur y Este-Oeste, ofrece una gestión unificada de las políticas, proporciona aislamiento del rendimiento y elude los problemas de latencia relacionados con el hair-pinning.

Los SASE unificados de empresas como Aryaka proporcionan una arquitectura que cumple muchos de los requisitos anteriores.

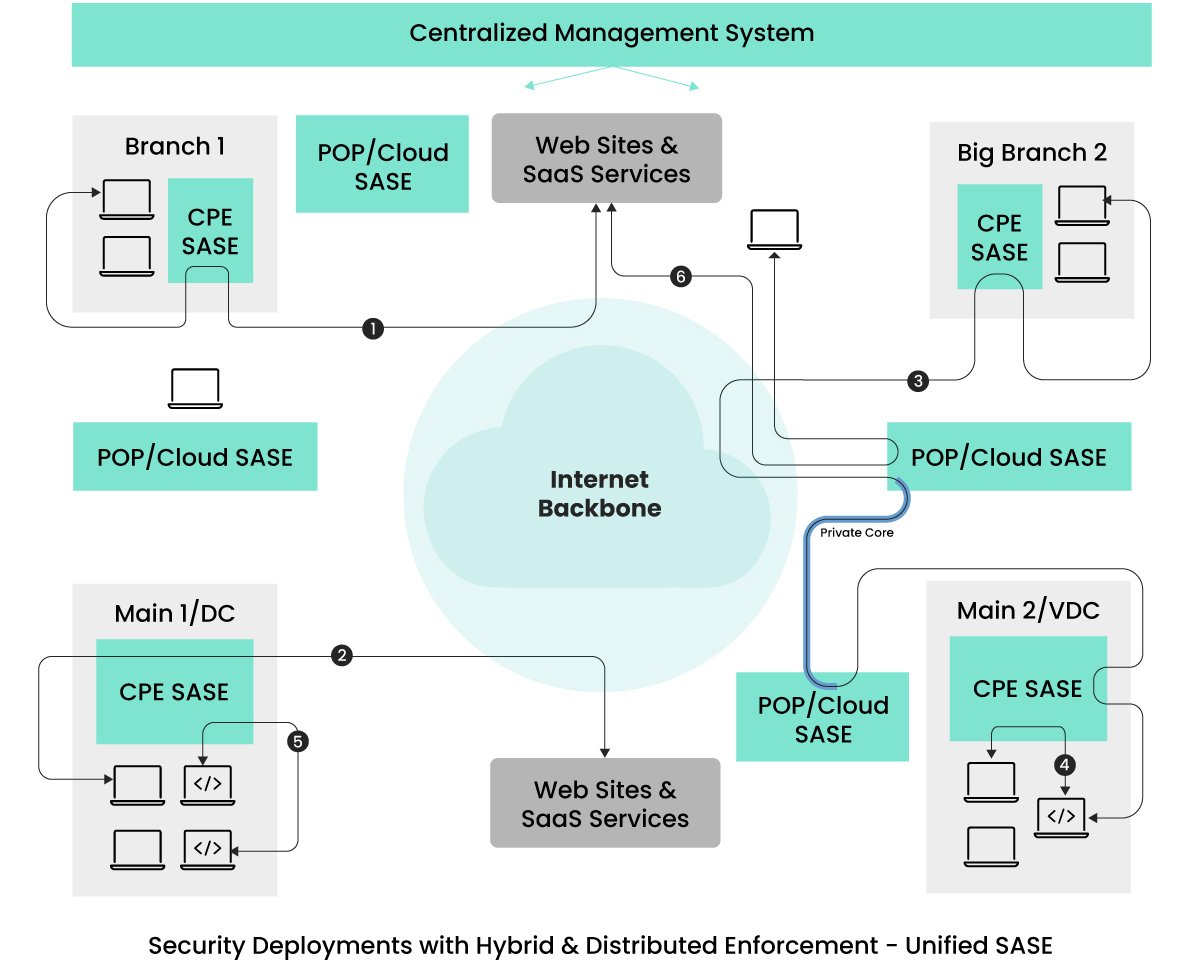

Vea la siguiente imagen.  Dentro de la arquitectura descrita, la aplicación de la red y la seguridad se extienden más allá de las ubicaciones POP/Cloud para abarcar los dispositivos CPE, todos ellos proporcionados y gestionados uniformemente por el mismo proveedor de servicios.

Dentro de la arquitectura descrita, la aplicación de la red y la seguridad se extienden más allá de las ubicaciones POP/Cloud para abarcar los dispositivos CPE, todos ellos proporcionados y gestionados uniformemente por el mismo proveedor de servicios.

Esta estrategia alivia las preocupaciones de los clientes sobre el mantenimiento de estos dispositivos CPE.

Sólo cuando estos dispositivos se encuentren con una sobrecarga de tráfico, el nuevo tráfico se dirigirá a las ubicaciones POP cercanas para reforzar la seguridad.

El volumen de tráfico redirigido a las ubicaciones POP depende de los modelos de dispositivos CPE seleccionados, lo que reduce el tráfico de retorno.

En cuanto al tráfico procedente de usuarios de acceso remoto (representado como 6), sigue un camino similar al de las arquitecturas anteriores.

El tráfico procedente de dispositivos de usuarios remotos se somete a un procesamiento de red y seguridad en la ubicación POP más cercana antes de llegar a su destino previsto.

Los flujos (1) y (2) de esta arquitectura eluden las ubicaciones POP, eliminando incluso las latencias mínimas presentes en las configuraciones de entrega en la nube.

Además, los flujos (4) y (5), contenidos dentro de un emplazamiento, no sólo eluden los gastos generales de latencia, sino que también reducen la superficie de ataque.

Esta aplicación local de la seguridad es esencial para aplicaciones en tiempo real como WebRTC, sensibles a los problemas de latencia.

Para los servicios de aplicaciones en diferentes sitios que necesitan un rendimiento determinista y de baja fluctuación, algunos proveedores de SASE ofrecen conectividad dedicada entre sitios a través de las ubicaciones POP más cercanas.

El flujo (3) ejemplifica los flujos de tráfico que se benefician del ancho de banda y los enlaces dedicados, eludiendo la red troncal de Internet para lograr un jitter determinista.

Es importante señalar que no todas las ofertas SASE unificadas son idénticas.

Algunos proveedores de SASE siguen redirigiendo todo el tráfico de las oficinas a las ubicaciones POP más cercanas para optimizar la red y garantizar la seguridad.

Aunque pueden mitigar la sobrecarga de latencia con múltiples ubicaciones POP, cualquier reducción de la latencia resulta ventajosa para las empresas, especialmente en previsión de posibles necesidades de aplicaciones de baja latencia.

Es probable que las empresas busquen soluciones que den prioridad a la facilidad de uso y a la seguridad de alto nivel sin comprometer el rendimiento ni la experiencia del usuario.

Dada la necesidad de un bajo jitter entre oficinas, las empresas deberían considerar proveedores que ofrezcan enlaces virtuales dedicados entre oficinas que eviten la red troncal de Internet.

Otro factor crucial para las empresas es seleccionar proveedores que gestionen el mantenimiento y las actualizaciones de software de los dispositivos SASE-CPE.

En los modelos heredados, las Empresas cargaban con la responsabilidad de las actualizaciones y sustituciones.

Para evitar esta preocupación, las Empresas deben considerar proveedores de servicios que ofrezcan servicios integrales gestionados de guante blanco que cubran todo el ciclo de vida de la infraestructura SASE, abarcando tareas como la gestión de dispositivos de equipos en las instalaciones del cliente (CPE), la configuración, las actualizaciones, la resolución de problemas y la observabilidad.

Estos proveedores actúan como ventanillas únicas, ocupándose de todos los aspectos de la red y la seguridad, al tiempo que ofrecen opciones de cogestión o autoservicio para las empresas.

Mirando hacia el futuro – SASE universal y unificado

Aunque el marco arquitectónico existente, «SASE unificado con seguridad distribuida», cumple satisfactoriamente varios requisitos iniciales detallados en el artículo, existen estrategias adicionales para mejorar el rendimiento de las aplicaciones sin comprometer la integridad de la seguridad.

De cara al futuro, prevemos avances en la aplicación de la seguridad y la optimización del tráfico más allá de los POP y el borde de las oficinas.

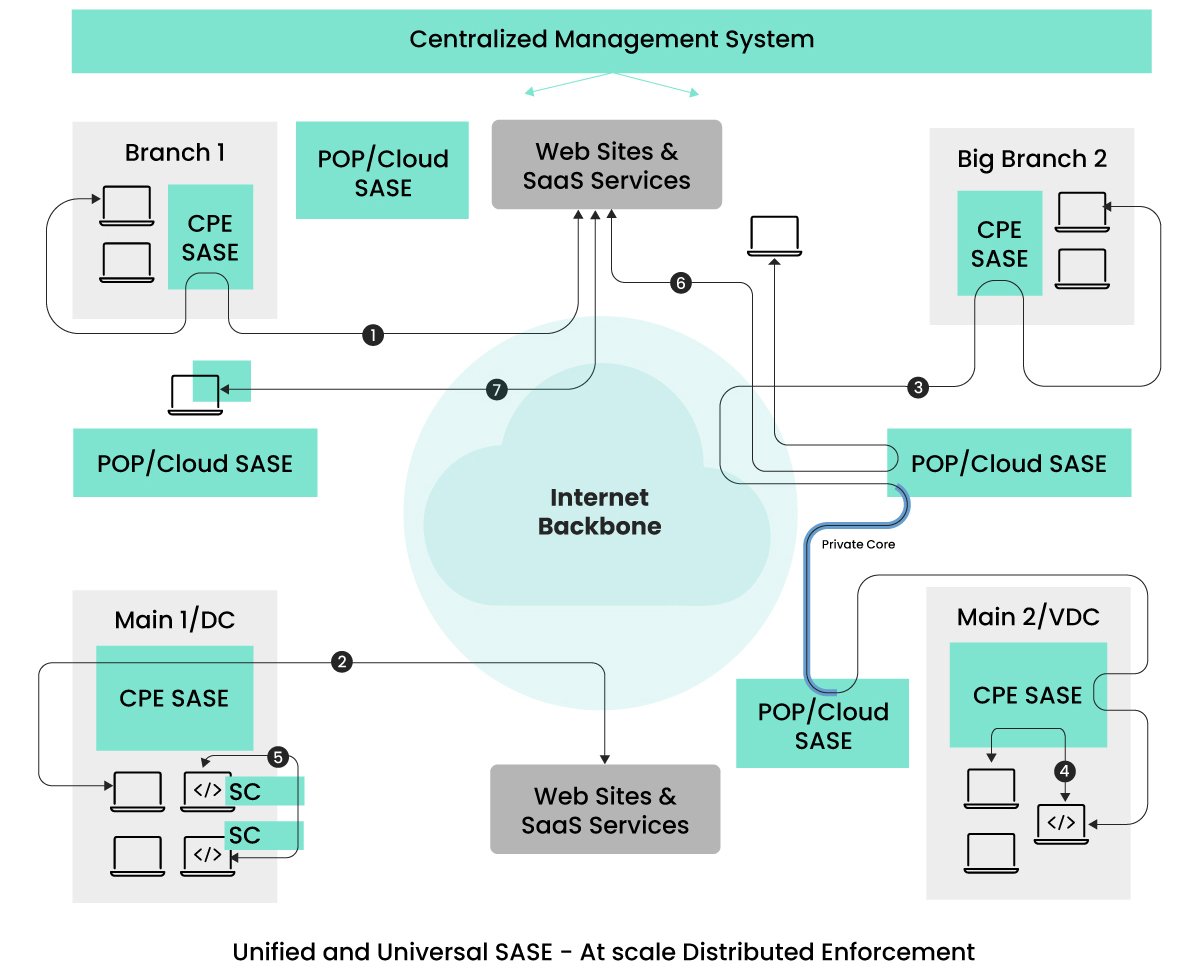

Estos nuevos enfoques arquitectónicos se centrarán en los flujos (5) y (7), dirigidos específicamente a mejorar el aspecto de latencia del rendimiento.  Como se ilustra en la imagen, el concepto de aplicar la seguridad y la optimización de forma universal, sobre todo en el origen del tráfico, puede producir un rendimiento óptimo.

Como se ilustra en la imagen, el concepto de aplicar la seguridad y la optimización de forma universal, sobre todo en el origen del tráfico, puede producir un rendimiento óptimo.

Los flujos de tráfico clave a tener en cuenta se representan como (5) y (7).

La prevalencia de las arquitecturas de aplicaciones basadas en micro/miniservicios se está convirtiendo en un estándar en el panorama de las aplicaciones.

Estos miniservicios pueden desplegarse dentro de clústeres Kubernetes, repartidos en clústeres dentro de centros de datos o en diferentes ubicaciones geográficas.

En los escenarios en los que existen servicios comunicados dentro del mismo clúster de Kubernetes, resulta ventajoso garantizar que el tráfico permanezca dentro del clúster, lo que permite aplicar la seguridad y la optimización directamente dentro del entorno de Kubernetes.

Kubernetes facilita la adición de sidecars a los POD que alojan los miniservicios.

Prevemos que los proveedores de SASE aprovecharán esta característica en el futuro para ofrecer funciones integrales de seguridad y optimización, cumpliendo los requisitos de confianza cero sin comprometer el rendimiento.

Optar por un único proveedor SASE universal garantiza a las empresas una interfaz de gestión unificada para todas sus necesidades de seguridad, independientemente de la ubicación de los servicios comunicantes.

El flujo (5) de la imagen representa la aplicación de la seguridad a través de carros laterales (SC).

Es importante señalar que los sidecars no son una novedad en el mundo de Kubernetes; las tecnologías de malla de servicios utilizan un enfoque similar para la gestión del tráfico.

Algunos proveedores de malla de servicios han empezado a integrar la seguridad contra amenazas, como WAAP, en los sidecars.

Teniendo en cuenta que los servicios pueden comunicarse con Internet y con otros servicios SaaS, es esencial contar con medidas de seguridad exhaustivas.

En consecuencia, es previsible que en el futuro se produzca una convergencia entre la malla de servicios y el SASE, ya que las empresas buscan una solución integral y unificada.

El tráfico representado como (7) es una consideración que muchos proveedores de SASE están explorando, lo que implica no sólo disponer de funcionalidad de cliente VPN, sino también realizar funciones SASE directamente en el punto final.

Extender SASE a los puntos finales ayuda a eludir cualquier preocupación de latencia asociada a las ubicaciones POP.

A medida que los puntos finales crecen en potencia computacional y ofrecen mejores controles para evitar la denegación de servicio por parte de entidades maliciosas, se ha hecho factible extender la aplicación de SASE a los puntos finales.

Mientras que los proveedores de servicios se encargan de la carga de mantenimiento en el lado de SASE, las empresas pueden seguir necesitando asegurarse de que la aplicación de SASE en los puntos finales no introduce nuevos problemas.

Por lo tanto, las empresas buscan flexibilidad a la hora de permitir la extensión de SASE a los puntos finales, específicamente para los usuarios avanzados.

Reflexiones finales

Este artículo ha ilustrado la evolución de la red y la seguridad, trazando un recorrido desde los sistemas heredados hasta las modernas soluciones en la nube, el SASE unificado con aplicación distribuida y los futuros diseños arquitectónicos prospectivos.

Es primordial reconocer las variaciones en la oferta de soluciones.

Las empresas deben llevar a cabo evaluaciones exhaustivas de los proveedores de servicios, buscando soluciones «as-a-service» que cubran la aplicación distribuida a través de PoPs y dispositivos CPE, que abarquen las actualizaciones de SO y software, manteniendo al mismo tiempo prácticas de gestión coherentes que defiendan tanto la seguridad como el rendimiento.

Además, es fundamental que las empresas den prioridad a los servicios gestionados (o cogestionados) de un único proveedor.

Estos servicios no sólo deben proporcionar soluciones de conectividad a Internet con un soporte técnico avanzado, sino también adaptarse rápidamente a los nuevos requisitos y hacer frente a las amenazas emergentes.

Optar por proveedores de servicios gestionados que utilicen as-a-service de otros proveedores de SASE puede acarrear complicaciones en futuras mejoras, lo que supondría negociaciones prolongadas entre los proveedores de servicios gestionados y los de tecnología.

Dada la imperiosa necesidad de resoluciones rápidas, creo que las soluciones SASE unificadas con ofertas integrales de servicios gestionados de un solo proveedor se erigen como la opción ideal para las empresas.

-

Blog CTO Insights

La serie de blogs Aryaka CTO Insights proporciona liderazgo de pensamiento para temas de red, seguridad y SASE.

Para conocer las especificaciones de los productos Aryaka, consulte Aryaka Datasheets.